Red Hat schaalt AI-inferentie met Red Hat AI 3

|

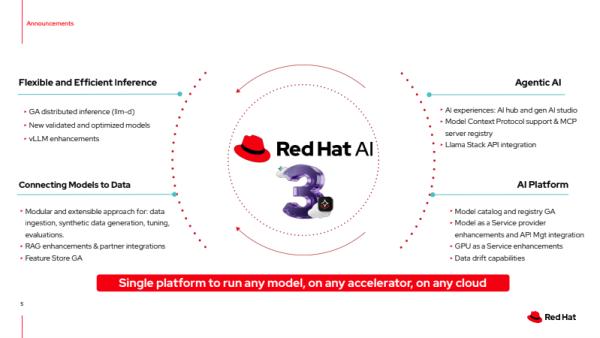

Het hybride, cloud-native AI-platform van Red Hat stroomlijnt AI-workflows en voegt krachtige nieuwe inferentiemogelijkheden toe Amsterdam, 14 oktober 2025 – Red Hat, marktleider in enterprise open source‑oplossingen, kondigt vandaag Red Hat AI 3 aan, een grote stap vooruit voor zijn enterprise AI-platform. Door de nieuwste innovaties van Red Hat AI Inference Server, Red Hat Enterprise Linux AI (RHEL AI) en Red Hat OpenShift AI samen te brengen, helpt het platform bedrijven om de complexiteit van grootschalige AI-inferentie te vereenvoudigen. Organisaties kunnen zo hun AI-workloads vlotter van proof-of-concept naar productie brengen en beter samenwerken rond AI-gestuurde toepassingen. Nu organisaties verder gaan dan experimenteren met AI, stuiten ze op uitdagingen zoals dataprivacy, kostenbeheersing en het beheer van uiteenlopende modellen. “The GenAI Divide: State of AI in Business” van het NANDA‑project van het Massachusetts Institute of Technology schetst de realiteit van AI in productie: 95% van de organisaties ziet naar schatting geen meetbaar financieel rendement op de ongeveer 40 miljard dollar aan bedrijfsuitgaven. Red Hat AI 3 pakt die problemen rechtstreeks aan met een consistent en eenduidig platform voor CIO’s en IT-leiders, zodat ze hun investeringen in versnelde computertoepassingen maximaal kunnen benutten. Het maakt het mogelijk om AI-workloads snel op te schalen en te verdelen over hybride, multi-vendor omgevingen, terwijl samenwerking tussen teams rond nieuwe AI-toepassingen zoals agents eenvoudiger wordt. Gebouwd op open standaarden sluit Red Hat AI 3 aan bij elke stap in de AI-reis van een organisatie, ongeacht model of hardware, van datacenters tot publieke cloud en soevereine AI-omgevingen tot aan de edge. |

Afbeelding Red Hat AI 3

|

|

Van trainen naar doen: de verschuiving naar enterprise AI-inferentie Wanneer organisaties AI naar productie brengen, verschuift de focus van trainen en finetunen naar inferentie: de fase waarin AI effectief “doet”. Red Hat AI 3 legt de nadruk op schaalbare en kostenefficiënte inferentie, gebouwd op de succesvolle open source-projecten vLLM en llm-d, gecombineerd met Red Hat’s eigen optimalisatiecapaciteiten. Zo kunnen bedrijven grote taalmodellen (LLM’s) betrouwbaar in productie inzetten. Om CIO’s te helpen het maximale uit hun kostbare hardware te halen, introduceert Red Hat OpenShift AI 3.0 de algemene beschikbaarheid van llm-d. Dat project herdefinieert hoe LLM’s native draaien op Kubernetes. llm-d maakt slimme, gedistribueerde inferentie mogelijk, waarbij de kracht van Kubernetes-orkestratie en de prestaties van vLLM worden gecombineerd met open source-technologieën zoals de Kubernetes Gateway API Inference Extension, de NVIDIA Dynamo-bibliotheek voor snelle datatransfers (NIXL) en de DeepEP Mixture of Experts (MoE)-communicatielaag. Zo kunnen organisaties:

llm-d bouwt verder op vLLM en evolueert van een single-node inferentie-engine naar een gedistribueerd, schaalbaar systeem, strak geïntegreerd met Kubernetes. Het is ontworpen om voorspelbare prestaties, meetbare ROI en efficiënt infrastructuurbeheer mogelijk te maken. Alle verbeteringen spelen in op de uitdagingen van wisselende LLM-workloads en het serveren van gigantische modellen zoals Mixture-of-Experts. Een verenigd platform voor samenwerkende AI Red Hat AI 3 brengt een geïntegreerde, flexibele ervaring die inspeelt op de behoefte aan samenwerking bij het bouwen van generatieve AI-oplossingen op productieniveau. Het platform creëert tastbare meerwaarde door teams te verbinden en workflows te stroomlijnen binnen één omgeving waar zowel platform- als AI-engineers hun AI-strategie kunnen uitvoeren. Nieuwe functies helpen bedrijven de stap te zetten van proof-of-concept naar productie met meer efficiëntie en productiviteit.

De basis voor de volgende generatie AI-agents AI-agents staan op het punt om de manier waarop applicaties gebouwd worden grondig te veranderen. Hun complexe, autonome workflows stellen zware eisen aan inferentiecapaciteiten. De nieuwste Red Hat OpenShift AI 3.0-release bouwt voort op die basis, niet alleen via verbeterde inferentie, maar ook via nieuwe functies voor agentbeheer. Om het bouwen en uitrollen van agents te versnellen, introduceert Red Hat een Unified API-laag gebaseerd op Llama Stack, die de ontwikkeling afstemt op industriestandaarden zoals OpenAI-compatibele LLM-protocollen. Daarnaast ondersteunt Red Hat als vroege adoptant het Model Context Protocol (MCP), een nieuwe open standaard die bepaalt hoe AI-modellen communiceren met externe tools. Dit vormt een cruciaal fundament voor moderne AI-agents. Red Hat AI 3 bevat ook een modulair en uit te breiden toolkit voor modelaanpassing, gebaseerd op InstructLab. Het biedt gespecialiseerde Python-bibliotheken waarmee ontwikkelaars meer controle en flexibiliteit krijgen. Het toolkit gebruikt open source-projecten zoals Docling voor gegevensverwerking, die ongestructureerde documenten omzet naar een AI-leesbaar formaat. Verder omvat het een flexibel kader voor synthetische datageneratie en een training hub voor LLM-finetuning. Het geïntegreerde evaluatiecentrum helpt AI-engineers resultaten te valideren en op te volgen, zodat ze hun eigen data met vertrouwen kunnen inzetten voor accuratere en relevantere AI-uitkomsten. |

Dit artikel is een ingezonden bericht en valt buiten de verantwoordelijkheid van de redactie.