Zo check je de techniek achter de SEO van je website

Uitstekende content en relevante inbound links zijn waarschijnlijk de twee belangrijkste SEO-ranking factoren. Maar als de spiders van zoekmachines je website niet goed kunnen vinden en crawlen, dan zullen je webpagina’s moeilijk kunnen opduiken in de zoekresultaten. Gevolg: al je SEO-inspanningen zijn voor niets.

Dit artikel beschrijft die technische aspecten die evengoed noodzakelijk zijn om hoog te scoren in de zoekmachines. De meesten aspecten zijn ongetwijfeld al bekend, maar worden o zo vaak in het heetst van de SEO-strijd over het hoofd gezien.

Crawlen en indexeren

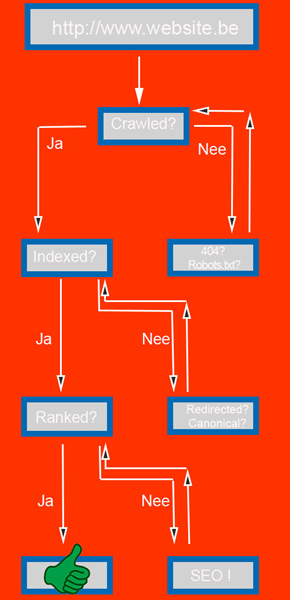

Eenvoudig gezegd voeren zoekmachines drie opdrachten uit:

- Het vinden (= crawlen) van internet-pagina’s

- Het catalogiseren (= indexeren) van de gevonden web-info

- De beste zoekresultaten tonen voor iedere zoekopdracht

Zoekmachines crawlen webpagina’s om te achterhalen of de content ervan waardevol en relevant genoeg is voor specifieke zoekopdrachten. Zo ja, pas dan worden ze geïndexeerd. Gecrawlde webpages worden in een enorme index gezet, waarbij per pagina onder meer de content, meta-informatie en locatie worden opgelijst. Zodra iemand op het net een zoekopdracht uitvoert, wordt die super-index doorzocht op de meest relevante resultaten om de beste zoekresultaten vervolgens te tonen. Dit allemaal in een fractie van een seconde.

Met andere woorden: als een webpagina is geïndexeerd, dan is die als gevolg daarvan ook crawlbaar en kan dus weergegeven worden in de zoekresultaten. Maar het omgekeerde geldt ook: internetpagina’s die niet gecrawled of geïndexeerd kunnen worden verschijnen nooit in de SERP’s. Daarom is het echt wel interessant om te achterhalen welke URL’s niet worden geïndexeerd door Google. Kan je achterhalen waarom precies en dat oplossen, dan geef je je SEO-posities een mooie boost.

Waarom niet geïndexeerd ?

- Bij opstartende websites duurt het een poosje voordat de searchbots ze hebben ontdekt. Probeer een link van een andere, reeds geïndexeerde webpage te ontvangen waardoor de zoekmachines tijdens hun crawlproces ook de jouwe vinden.

- Hoe ‘dieper’ URL’s verscholen zitten op een website, hoe moeilijker crawlbaar. Oplossing: internal linking vanaf de homepage of van juist eronder liggende pagina’s. Tracht nieuwe URL’s steeds niet te ver van de domeinnaam te plaatsen.

- Duplicate content veroorzaakt ook SEO-problemen. Voor zoekmachines telt alleen de originele webpagina; de kopie ervan of sterk gelijkende pagina’s bevuilen alleen maar de indexen. Komen bots ( grote hoeveelheden) duplicate content tegen, dan zullen ze die URL’s, en de daaronder liggende non-duplicated-content-pagina’s, vaak niet crawlen. Oplossing: enkel unieke content op elke pagina, 301-redirecten, 404’s en canonical tags.

- Weet dat een URL die zowel bereikbaar is met en zonder de www of via http en https, voor de sitemap telt als 1 pagina, maar als indexstatus 2 heeft.

Lesson learned: zorg ervoor dat alle gewenste pagina’s van je site crawlbaar en indexbaar zijn. Anders hebben al je andere SEO-inspanningen geen zin.

Webmaster tools

Google search console

De meeste online marketeers kennen uiteraard Google Search Console. Het is een degelijke, gratis tool om te zien hoe vaak Google je website crawlt, of je URL’s geïndexeerd worden en om technische manco’s op te sporen.

Webmastertools Bing

Google search is met zijn marktaandeel van meer dan 90 procent in Nederland by far de meest gebruikte zoekmachine, maar niet de enige. Zo was Bing in Q2 van 2016 op desktop & laptops goed voor 6,5 procent. Het loont dus best wel de moeite om je ook in te schrijven op Bing’s Webmaster tools.

Leason learned: gebruik de twee bovenstaande tools om je technische SEO op regelmatige basis te monitoren in Google en Bing.

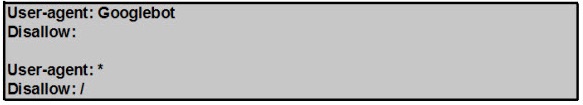

Robots.txt

Een goed geoptimaliseerde website bevat een robots.txt-filetje. Robots.txt is een klein tekstbestandje die webmasters de mogelijkheid geven om de crawlbots van zoekmachines te beletten bepaalde gebieden van een site te crawlen. Zoals bijvoorbeeld members-only pagina’s.

In dat robots-bestandje kan je bijvoorbeeld zeggen ‘ik wil niet dat de Chinese zoekmachine Baidu mijn website spidert’. Als je geen interesse hebt in de Aziatische markt, kan dit een optie zijn. Immers, het spideren belast een website in meerdere of mindere mate en leidt soms tot hogere laadtijden.

Het gebeurt vaker dan je voor mogelijk houdt dat robots.txt onbewust (goede) zoekrobots zoals Googlebot blokkeren, met ‘onverklaarbaar’ verlies aan online bezoekers tot gevolg. Daarom, check je robots.txt-file of die nog up-to-date is ! Je kan dit eenvoudig in de Search Console doen onder Crawlen/robots.txt-tester .

Leason learned: weet zeker dat je site een robots.txt heeft en dat geen delen ervan per ongeluk geblokkeerd worden. Anders heb je een mega SEO-probleem.

Canonicalization

Deze tag is erg praktisch indien gelijkaardige webpagina’s kunnen aangeroepen worden via verschillende URL’s. Canonieke fouten komen veel meer voor dan je zou vermoeden en zijn erg funest voor zoekmachine-optimalisatie.

Zo zijn http://www.voorbeeld.nl/tennisrackets, http://voorbeeld.nl /tennisrackets en http://www.voorbeeld.nl/tennisrackets?sort=prijs technisch gezien 3 verschillende URLs, ook al is de content op de pagina’s identiek.

Is dat erg ? Toch wel, zeker voor je pagina-autoriteit. De waarde van een externe backlink naar een van de URL’s uit ons voorbeeld wordt immers eveneens verdeeld. De zoekmachines geven de drie URL’s afzonderlijk linkwaarde. Veel interessanter voor de SEO zou zijn als de inkomende links gebundeld zouden worden op slechts een URL. Bovendien zien de zoekmachines al de bovenstaande pagina’s als duplicate content, wat je SERP’s niet ten goede gaat komen.

Je kan dit rechtzetten via een zogenaamde rel=”canonical” tag, die aan de zoekmachines duidelijk maakt wat de hoofd- of canonieke URL is. Je plaats de tag in de html header, waar ook onder meer de meta description en de page title staan van elke webpagina.

Als de html-code <link rel=”canonical” href=”http://www.voorbeeld.nl/tennisrackets”> in de <head> van de URL http://voorbeeld.nl/tennisrackets zou staan, dan vertelt de tag aan Bing&Google&co dat de pagina http://voorbeeld.nl/tennisrackets een copy is van http://www.voorbeeld.nl/tennisrackets en dat alle content en link-waarde van toepassing zijn op de hoofd-URL.

Leason learned: ga na of je webpagina’s rel=”canonical” bevatten en zo ja, controleer of ze nog actueel zijn.

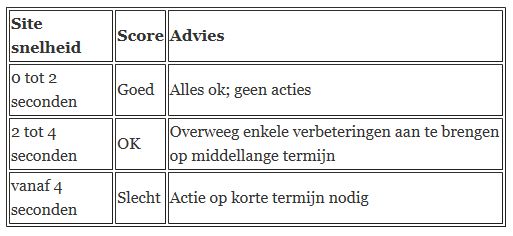

Laadsnelheid

Snelle websites zijn het nieuwe ‘je van het’ en een bepalende SEO-factor voor meer traffic en conversies. Hoe sneller, hoe beter. Enkele algemene richtlijnen:

De onderstaande zaken helpen je de sitesnelheid te analyseren en te verbeteren:

Pagespeed

Gebruik Google’s Pagespeed Insights om de laadsnelheid van je internetsite op permanente basis te monitoren, zowel voor mobiel als desktop verkeer. Het is een praktische tool om na te gaan waarom je homepage en andere pagina’s traag laden.

Snelheidstesters

GTmetrix en Pingdom zijn twee handige gratis tools voor bijkomende tips ter verbetering van de sitesnelheid. Dit voor verschillende browsers, locaties en soorten internetverbindingen.

Hosting

‘If you pay peanuts, you get monkeys’. Als je slechts tien euro per maand betaalt voor je hosting mag je niet verwachten dat je een razendsnelle website zal hebben. Afhankelijk van je bezoekersaantallen kan je overwegen je hosting te upgraden voor snellere laadtijden.

Klein, kleiner & kleinst

Eenvoudig gesteld maak je een webpagina sneller door alles erop zo klein en licht mogelijk te maken en te houden. Denk hierbij aan volgende elementen:

- gecompresseerde afbeeldingen van < 50kb

- minder browser requests

- caching

- geen broken links

- gecompresseerde CSS files

- nette html

Leason learned: een trage website is een indicatie dat de SEO verder verbeterd kan/moet worden !

Mobiel

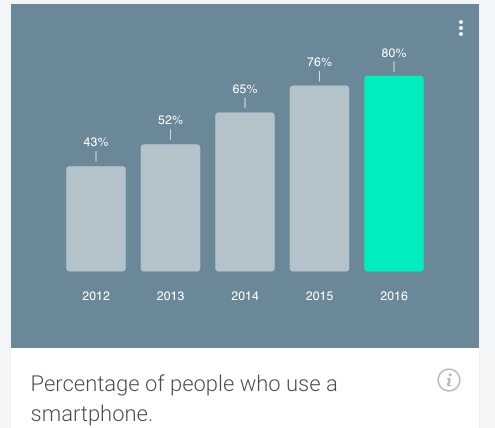

In 2015 maakte Google bekend dat mobile-friendly voortaan een belangrijke ranking factor is geworden. Het al dan niet hoog ranken in de SERP’s hangt dus (onder andere) af of een bestemmingspagina mobielvriendelijk is of niet. Anno 2016 wordt er meer dan ooit mobiel gesurft (de recentste cijfers van de Google Consumer Barometer voor Nederland bevestigen dit) en de zoekmachinegigant volgt hier gewoon wat haar gebruikers willen. Mobiele surfers die voor een zoekopdracht op een klassieke webpagina terechtkomen, klikken in veel gevallen gewoon weg omdat die sites te traag laden, iets wat ze in Mountain View, California, absoluut niet graag zien.

Hierbij enkele adviezen op je site mobielvriendelijk(er) te maken:

Nu

- is je website nog niet mobielvriendelijk, dan is dat echt wel een probleem voor je SEO

- test hem als de bliksem via deze gratis toolis de uitslag negatief, start dan vandaag nog een project om hem wel mobile friendly te maken.

Responsive

- een site met een responsive design past zichzelf aan in functie van de afmetingen van het beelscherm waarmee de bezoeker surft. Het is dus dezelfde website, die er iets anders uitziet op pc, tablet of smartphone

- de optie om een separate mobiele m-domein in te zetten, kies je best niet omdat je dan twee aparte websites moet onderhouden, wat veel duurder uitvalt

Keep it simple

- gebruik voor call-to-actions geen tekst-links, maar duidelijke icons.

- zet tekst en buttons niet te dicht bij elkaar. Vermijd pop-ups, zooming, flash, frames, enzovoorts.

Leason learned: Niet mobielbriendelijk = geen goede SEO rankings.

Sitemap

- Elke degelijke website hoort over een sitemap te beschikken.

- Een sitemap helpt zoekmachines om de structuur van een website beter te begrijpen.

- Een sitemap garandeert niet dat zoekmachines alle opgegeven webpagina’s zal crawlen en indexeren. Het is een soort houvast die search engines duidelijk maken welke pagina’s ze moeten crawlen, echter dus zonder garantie dat die ook effectief geïndexeerd zullen worden.

- Ze zijn een indicator dat het een goed gestructureerde en indexeerbare website betreft, wat je SEO ten goede komt

- Heeft jouw site er nog geen ? Ga dan niet zelf liggen programmeren, maar laat er 1 gratis voor je genereren.

- Controleer, bijvoorbeeld in Search Console, op regelmatige basis of de sitemap van je site nog correct werkt en los eventuele waarschuwingen op.

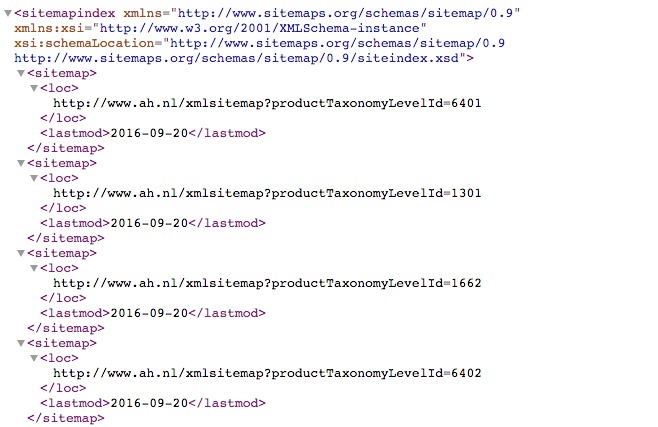

- Sitemaps zien er niet echt ‘cool’ uit; dit is bijvoorbeeld de sitemap.xml van AH.nl.

Lesson learned: geen sitemap = slechtere SEO.

Besluit

In deze blogpost een aantal aandachtspunten om de technische SEO van een website in kaart te brengen. Het behandelt zeker niet alle aspecten, maar het geeft je toch al een stevige houvast.

Gerelateerd event

Deel dit bericht

Plaats een reactie

Uw e-mailadres wordt niet op de site getoond

11 Reacties

Nicolas

Welke bedrijven raden jullie aan die sterk zijn in SEO?

Imre Bernáth

Er is een verwijzing naar pagespeed insights, die tool is prima, maar er is sinds kort een nieuwere versie van Google voor het testen van je website snelheid en met name mobiele website snelheid.

https://testmysite.thinkwithgoogle.com/

Met vriendelijke groet,

Imre Bernáth

SEO specialist

Tammo Peters (PROSEO)

Goed artikel James. Kleine aanvulling op het stukje over de robots.txt. Het hebben van een robots.txt is geen noodzaak. Het voorkomen van een verkeerde robots.txt daarentegen wel.

Voor de technische kant van SEO kan een pakket als Screaming Frog ook heel handig zijn. Dit programma kan heel veel (o.a. genereren van sitemaps, testen van snelheid, testen of de website gecrawld kan worden etc.).

Arie vd Giesen

Gtmetrix en pingdom zijn goede tools.

ze hebben alleen 1 groot nadeel; ze testen de snelheid van jouw website uit het buitenland.

En dan is jouw website standaard al langzamer, dan dat je meet vanuit Nederland.

bij https://www.webpagetest.org/ kun je ook vanuit Nederland testen, dat geeft een beter en realistischer beeld.

Je winst is vooral te halen uit het minimaliseren van (grote) afbeeldingen en javascripts.

Kijk ook goed hoeveel externe content (zoals Google analytics, jquery) die je vanaf andere servers ophaalt.

Zeker wanneer je SSL gebruikt, dan is de SSL handshake een aardige tijdslurper, die jouw website kan vertragen, wanneer 1 van de externe sites een probleemje heeft.

Gebruik je veel van dit soort externe sites, dan is 1 vertraging, al genoeg om jouw hele website langzaam te laden

en dus langzaam te ranken.

Meer tips vindt je op http://performanceadvies.nl/

Toos

Hoi James, wat bedoel je met “gebruik voor call-to-actions geen tekst-links, maar duidelijke icons.” Waarom zijn icons (afbeelding?) beter dan tekst links?

@Nicolas: google eens op “seo” en kijk welke bedrijven hoog scoren in google 🙂

De SEO expert

Om een duidelijk beeld te krijgen van je rankings maken wij gebruik van http://www.seorankmonitor.com/

Screaming Frog is een must om de technische kant van je website te analyseren!

Guido Marchal (SEO-SNEL)

Je kunt het beste deze gebruiken: https://developers.google.com/speed/pagespeed/insights/

Google is de standaard ook voor de meting van je website snelheid.

Edon van Asseldonk

Quote uit artikel:”In 2015 maakte Google bekend dat mobile-friendly voortaan een belangrijke ranking factor is geworden.”

Dit geldt alleen voor de zoekresultaten op mobiele apparaten, zoals smartphones. Niet-mobielvriendelijke websites worden niet benadeeld bij zoekopdrachten in Google op desktops en laptops. Desalniettemin blijft een mobielvriendelijke website een must anno 2016.

David Otherbeek - Taxi vervoer Amsterdam

Dank jullie wel voor de handige tips en trics.

Dit zal onze website namelijk https://schipholtaxi247.com/ zeker helpen om op pagina 1 te komen.

Met vriendelijke groet,

Team Schiphol Taxi 24/7

M. Ivn

Is hier iemand aanwezig die een crawl programma kan bouwen? Het gaat hier om millisecondes winnen.

Linkbaas.nl - Linkbaas.nl

Goeie tips, ook in 2021 nog relevant.