Wanneer heeft A/B-testen zin en wat zijn de alternatieven?

Er zijn vele vormen waarop een A/B-test uitgevoerd kan worden. Slechts variatie op een enkel element van de pagina (bijvoorbeeld de kleur van een knop), maar ook variatie in de volledige opmaak van een pagina. Wanneer kun je nu het beste welke vorm toepassen en wanneer is het resultaat betrouwbaar en dus duurzaam?

Drie uitdagingen die A/B-testen niet zo eenvoudig maken als het lijkt

A/B-testen is een van de populairste en meest gebruikte methoden in conversie optimalisatie land. Dankzij de opkomst van laagdrempelige tools zoals Optimizely of Visual Website Optimizer is A/B-testen voor bijna elke website toegankelijk geworden.

‘A/B-testen is de meest simpele variant van testen.’ –Web Analytics Association Nederland

‘Tools nemen een groot deel van het werk uit handen.’ –Marketingfacts

‘Met behulp van A/B-tests kun je makkelijk meer kansen voor je salesteam creëren.’ -Frankwachting

Het gemak waarmee A/B-tests tegenwoordig geïmplementeerd kunnen worden zorgt er voor dat de methode vaak verkeerd wordt ingezet en dat snel onjuiste conclusies worden getrokken. Waar moet je op letten om je A/B-test wél succesvol in te kunnen zetten?

- De juiste vraag en hypothese stellen om het doel te bereiken

- De juiste methode toepassen om het antwoord op de vraag te vinden

- De juiste conclusies trekken uit het resultaat van de methode

De juiste vraag en hypothese

Een goede A/B-test begint met de juiste vraag. Maar hoe kom je tot de juiste vraag? Kijk naar je business doelen en vertaal deze naar KPI’s, voeg hier targets aan toe en vraag je vervolgens af hoe je deze targets kan halen en/of waarom je de targets (nog) niet haalt.

Goede onderzoeksvragen bedenk je dus niet zomaar, maar ontstaan vanuit grondige analyse vooraf. Hiervoor kun je bijvoorbeeld ook inzichten vanuit web analytics, enquêtes of andere onderzoeken gebruiken, omdat je hierdoor in kaart kunt brengen waar de grootste kansen liggen.

Een hoog uitvalpercentage op een stap in de checkout-funnel, een lage task-completion rate of veel vragen bij de klantenservice over de retourvoorwaarden zijn voorbeelden van mogelijke startpunten.

Ontwerp nieuwe variaties daarnaast altijd op basis van duidelijke hypotheses. In de hypothese verwoord je wat het probleem is dat je wilt oplossen, wat je moet doen om het te verhelpen en hoe je bepaalt of de test succesvol was of niet.

Door een hypothese op te stellen ben je genoodzaakt om goed na te denken over waarom je een A/B-test wilt uitvoeren en hoe je het gewenste doel kunt bereiken. Je test dan niet zomaar willekeurig elementen op je pagina op zoek naar conversieverbetering, maar je bent heel doelgericht bezig, waardoor de kans op een succesvolle A/B-test toeneemt.

De juiste methode

Nu heb je dus een goede basis voor een A/B-test. Maar hoe weet je dan of A/B-testen als methode wel of niet geschikt is voor de onderzoeksvraag en hypothese? We hebben een overzicht voor je gemaakt.

Wanneer wél A/B-testen:

- Om continu te optimaliseren op de conversiedoelen aan de hand van inzichten uit onder anderen analyses en eerdere testresultaten

- Om te controleren of een gewenste wijziging geen negatief effect heeft

- Om inzichtelijk te maken of een bepaalde investering zich via conversieverhoging terugverdient

- Om de beste van verschillende oplossingen tegen elkaar af te wegen

Wanneer niét A/B-testen:

- Bij overduidelijke verbeteringen waarbij de effort (tijd, kosten, capaciteit) om het te testen groter is dan de effort om het te implementeren

- Als de verwachte impact te klein is (het verschil tussen de varianten is niet opvallend genoeg)

- Als de testcondities niet zuiver genoeg zijn om er conclusies uit te kunnen trekken

- Als er onvoldoende verkeer op de website is om binnen een korte periode significante verschillen aan te kunnen tonen

Alternatieven

Soms is het dus niet mogelijk of raadzaam om een A/B-test uit te voeren. Maar gelukkig zijn er een handvol mogelijke alternatieven.

Multivariate test

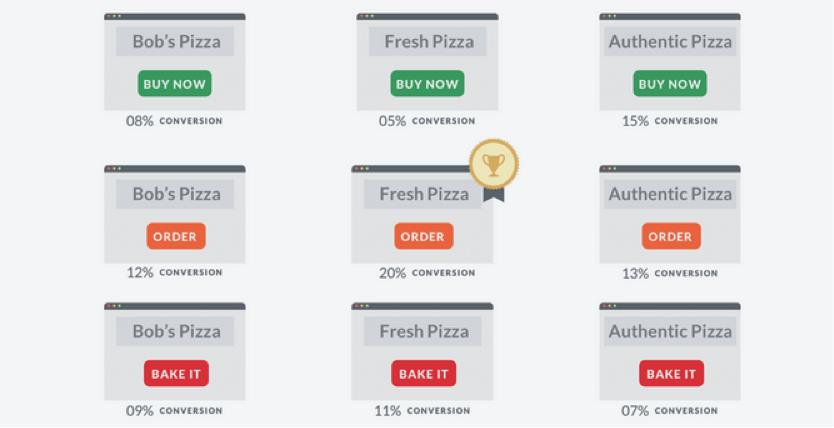

Bij een multivariate test worden meerdere elementen op de website geselecteerd en vervolgens voor alle gekozen elementen variaties aangemaakt. Al deze variaties worden gecombineerd. Als er bijvoorbeeld drie elementen getest worden, met telkens drie varianten, zouden er 3 x 3 = 9 combinaties ontstaan.

Al deze combinaties worden tegen elkaar afgezet met als doel om de combinatie die het beste resultaat oplevert te vinden.

Multivariate testen zijn vooral geschikt als een interactie-effect deel uit maakt van de hypothese: bijvoorbeeld, groene CTA in combinatie met die tekst, doet het beter dan oranje CTA in combinatie met die tekst, ondanks dat oranje het overall beter zou doen met verschillende teksten.

Daarnaast kunnen multivariate testen ook worden ingezet als je meerdere aanpassingen met duidelijk onderscheidende hypotheses in één keer wilt testen en het effect van beide aanpassingen afzonderlijk wilt zien.

Daarbij is echter heel veel verkeer nodig om bezoekers naar de verschillende varianten te sturen. Bovendien ben je langer bezig met het ontwikkelen van alle mogelijke variaties en duurt het langer om significante resultaten te behalen dan bij A/B-testen.

Als je van elke aanpassing afzonderlijk het effect wilt weten, ontbreekt namelijk makkelijker de afzonderlijke hypothese voor de wijzigingen. En/of wijzigingen hebben buiten de context niet het gewenste effect als binnen andere aanpassingen.

Multi-armed bandit

Bij multi-armed bandit experimenten is het doel om de meest rendabele variant te vinden en door een gerandomiseerde verdeling, die kan worden bijgewerkt tijdens het verloop van het experiment, het verkeer zo optimaal mogelijk te verdelen. Een variant die goed presteert krijgt op die manier meer verkeer dan een variant die slechter presteert.

Experimenten op basis van multi-armed bandits zijn daardoor in sommige gevallen efficiënter dan ‘klassieke’ A/B-tests, maar statistisch gezien even geldig. Met de extra gegevens die worden verzameld over de beter presterende varianten kunnen de goede varianten namelijk sneller van de slechte worden gescheiden, waardoor als het ware minder conversie ‘verspild’ wordt.

Maar er zitten ook nadelen aan verbonden. Een A/B-test is bijvoorbeeld makkelijker uit te voeren dan een multi-armed bandit experiment. Bepaalde instellingen bij het uitvoeren van een bandit experiment zijn moeilijk te om te beheren, bijvoorbeeld het updaten van een score voordat een nieuwe bezoeker aankomt.

Daarnaast ben je bij een A/B-test stapsgewijs aan het vernieuwen en heb je meer controle op het resultaat. Daarentegen wordt bij multi-armed bandit experimenten vooral ingezet op winstmaximalisatie en veel minder op het leren kennen van je klant.

Usability test

Een usability test is ook een mogelijkheid voor het evalueren van doorgevoerde verbeteringen: waar A/B-tests vooral antwoord geven op kwantitatieve vragen, richt een usability-test meer op het ‘waarom’. Daarom is een usability-test niet alleen een mogelijk alternatief voor A/B-tests, maar altijd ook een waardevolle aanvulling. Kwalitatief onderzoek levert namelijk vaak inzichten met meer diepgang op.

Pre-post analyse

Een ander alternatief om de prestatie van de verbetering te toetsen is het uitvoeren van een pre-post analyse. Daarbij vergelijk je de prestatie van de webshop voor- en nadat de wijziging volledig is doorgevoerd. Daar zijn wel een aantal risico’s aan verbonden, omdat de condities die invloed hebben op gebruikersgedrag in verschillende periodes heel erg verschillen. Denk aan specifieke acties en campagnes, verstuurde e-mail nieuwsbrieven, het seizoen, het nieuws, het weer, enzovoort. Het volgende artikel uit deze reeks zal richting geven over hoe met deze risico’s om te gaan.

Hoe maak ik hierin nu een keuze?

Bij het kiezen van de juiste methode is het streven altijd om keuzes te maken die gebaseerd zijn op een afweging tussen de verwachte kosten (tijd, geld en capaciteit) en baten (bijvoorbeeld conversieverhoging). Daarom is het belangrijk om een testplan op te stellen, waarin je vaststelt:

- waarom, wat en hoe je gaat testen

- welke KPI’s je hanteert om te bepalen wanneer de test succesvol is

- de verwachte looptijd

Door van te voren een testplan op te stellen kun je een weloverwogen beslissing nemen en waarborgen dat je door middel van de juiste methode effectief test.

De juiste conclusies

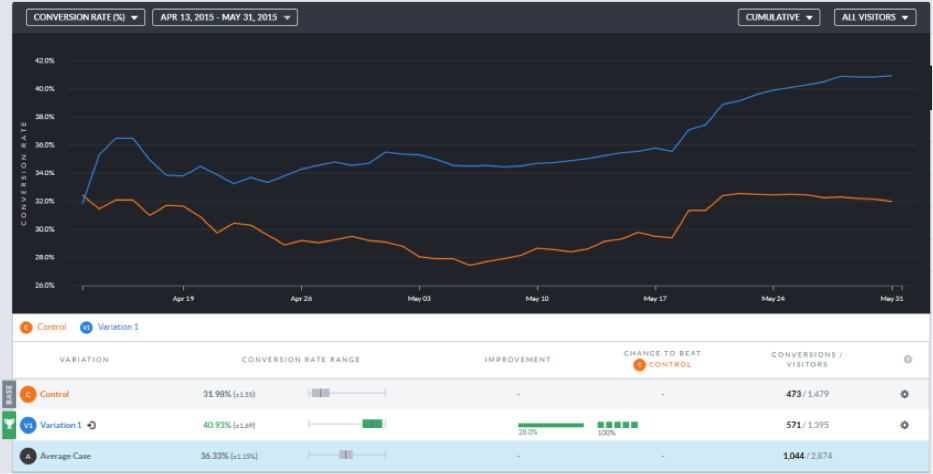

Je test is live en de eerste resultaten rollen binnen. Om de juiste conclusies te kunnen trekken moeten de resultaten in eerste instantie aan een statistische standaard voorwaarde voldoen: significantie. Maar wanneer is een test voldoende significant?

Hierover verschillen de meningen en het is een uitdaging om de juiste balans te vinden tussen betrouwbare resultaten en een pragmatische werkwijze. De officiële maat voor significatie is alpha. Dit is het foutpercentage dat je bereid bent te accepteren. Als je een alpha van 0.05 kiest, accepteer je bijvoorbeeld een foutpercentage van 5 procent en heb je nog 95 procent vertrouwen in de uitkomst van je test.

Als zekerheid belangrijk is voor de besluiten die je gaat nemen op basis van een A/B-test, is het zinnig om 95 procent significantie na te streven. Als een verkeerde keuze geringe risico’s met zich meebrengt, is het streven naar een hoge significantie minder belangrijk.

Dankzij tools als Visual Website Optimizer worden de resultaten op een makkelijke manier bijgehouden en gepresenteerd, inclusief informatie over significantie, improvement en dergelijke. Neem deze echter niet zomaar over. Kijk of de resultaten logisch zijn en denk na over de juiste conclusies.

Een rode button kan misschien wel 23 procent meer clicks opleveren dan een blauwe button, maar wat leer je hieruit? En welk effect heeft dit op je business doelstellingen? Wees dus niet tevreden met alleen een cijfermatig resultaat, zoek altijd een verklaring.

Laat niet alleen de tool voor je beslissen en neem de resultaten enkel mee als één onderdeel van je overweging om voor een bepaalde variant te kiezen. Als tester bezit je een hoop kennis en informatie die relevant kan zijn in het doorhakken van die uiteindelijke knoop. Omdat je meer informatie gebruikt dan de waarden die voor handen zijn, kan bijvoorbeeld zelfs al bij een kleine steekproef een definitieve uitslag volgen.

Om er écht zeker van te zijn dat een bepaalde optie inderdaad voor meer conversies zorgt kan er bovendien nog vervolgonderzoek worden gedaan. Bijvoorbeeld een tweede A/B-test die vergeleken kan worden met de eerste, of kwalitatief onderzoek als aanvulling. Dit is voornamelijk interessant als de mogelijke verandering kostbare en verreikende gevolgen met zich brengt.

Tot slot: Zie een test waarin geen conversieverbetering is gerealiseerd, niet als een mislukking, maar achterhaal waarom de hypothese niet bevestigd kon worden. Op deze manier kom je meer te weten over je bezoekers en kun je waardevolle ideeën opdoen voor een succesvolle vervolgtest.

Plaats een reactie

Uw e-mailadres wordt niet op de site getoond