Waarom de som van A/B-test winnaars niet je businesscase is

Je had vorig jaar 24 A/B-testen met een significant positief resultaat. Gemiddeld hadden ze drie procent effect op transacties, maar na implementatie van al deze winnaars in de loop van het jaar is je transactievolume niet met 24 x drie procent = 72% gestegen. Hoe kan dat?

Geen winnaars

De statistiek achter A/B-testen is ingewikkeld. Het is belangrijk om een vaste set aan afspraken te maken die de kwaliteit van de resultaten bewaakt. Tussendoor even spieken of de test al significant is? Het ligt aan je statistische model, maar ga er standaard maar van uit dat je dan winnaars ziet die geen winnaars zijn. Een grote afwijking van de ingestelde bezoekersverdeling tussen A en B (de SRM-error) kan ook zijn genegeerd, met als gevolg dat bijvoorbeeld een technisch inferieure inrichting zorgt voor het aanwijzen van een verkeerde winnaar. Datakwaliteit of überhaupt het aanwezig zijn van data is ook vaak een probleem. Als niet alles goed wordt gemeten, dan kunnen ook varianten als winnaars aangewezen worden die eigenlijk geen winnaars zijn.

Populatie

De A/B-test is vaak op een bepaalde pagina uitgevoerd waar niet de gehele populatie van bezoekers langs komt. Een drie procent gemeten effect als significante uitkomst over de helft van de populatie van de gehele website zal op het totaal natuurlijk slechts een anderhalf procent effect geven. Binnen de A/B-test uitslagen wordt ook vaak nog dieper doorgegraven om te begrijpen welk segment bezoekers dit positieve effect veroorzaakte. Misschien was het alleen op mobile het geval en is er geen significant effect op desktop? Misschien geldt het effect alleen voor Social Ads-bezoekers en niet voor de overige populatie? Als je dan alleen voor dat segment de verandering live zet, zal de impact ook minder groot zijn – nog los van de statstische gevaren bij eindeloos in segmenten speuren naar winnaars.

Overdrijving

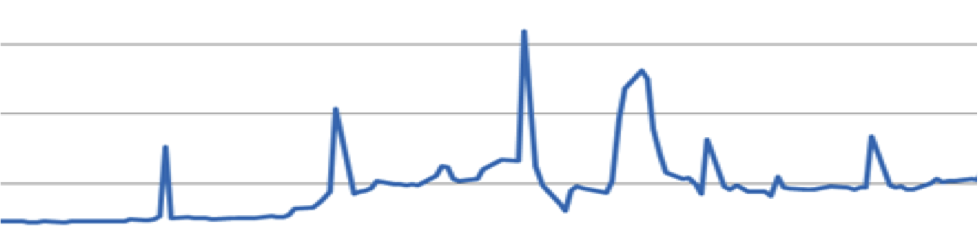

Wanneer je veel A/B-testen hebt uitgevoerd en veel winnaars gevonden hebt, kun je er van uitgaan dat het gemeten effect gelijk is aan het effect in realiteit. Alhoewel, niet helemaal. Het gemeten effect is een bandbreedte rondom de werkelijke conversie en als dit wat lager uitvalt in een test, kan het zijn dat het gemeten resultaat niet meer significant is. Je hebt een winnaar, maar je kon hem nu niet meten (een False Negative). Dit zorgt er voor dat het gemiddelde effect van de gemeten winnaars groter is dan het gemiddelde effect van alle metingen. Er is sprake van een Type-M error, die afhankelijk van je bezoekersaantallen kan zorgen voor het overdrijven van het echte effect van een significant resultaat met enkele tientallen procenten.

Onechte winnaars

Niemand A/B-test op honderd procent significantie. Een significantiegrens van negentig procent is in A/B-testland algemeen geaccepteerd als grens om winnaars te benoemen. Iedereen begrijpt dan dat als je honderd experimenten uitvoert die allemaal geen enkel effect hebben, dat je dan toch tien winnaars vindt. Dus als je na honderd A/B-testen maar tien winnaars hebt, zijn dit allemaal onechte winnaars (False Positives). Voor het berekenen van je businesscase kun je na correctie voor het populatiepercentage en de Type-M error wel het totaalresultaat van echt goed gemeten winnaars optellen, maar dan moet je dit nog vermenigvuldigen met de True Discovery Rate: de berekening van het percentage gemeten winnaars die ook echte winnaars zijn.

* Dit artikel verscheen eerder in het maartnummer van Emerce magazine (#176).

Over de auteur: Ton Wesseling is founding partner van Online Dialogue en schrijft columns voor Emerce.

Plaats een reactie

Uw e-mailadres wordt niet op de site getoond