Eén van de grootste sprongen in de geschiedenis van Search: BERT

Googles nieuwste zoekalgoritme update om de natuurlijke taal beter te begrijpen, genaamd BERT, heeft invloed op tien procent van alle zoekopdrachten. Google noemt het zelf de grootste stap voorwaarts in de laatste vijf jaar en één van de grootste sprongen in de geschiedenis van Search.

Vijftien procent van alle zoekopdrachten is uniek, dus nog nooit eerder uitgevoerd. Google moet algoritmes schrijven die daarmee om kunnen gaan.

Zelf weten we niet altijd onze zoekvraag op de juiste manier te formuleren. We maken het Google moeilijk doordat we niet altijd de juiste woorden weten, de spelling niet correct is, of juist zoeken om iets nieuws te leren. Om deze zoektermen beter te kunnen beantwoorden heeft Google BERT ontwikkeld.

BERT staat voor Bidirectional Encoder Representations from Transformers, een techniek voor natural language processing (NLP) die vorig jaar door Google is geïntroduceerd en open source is gemaakt. Met deze technologie kan iedereen zijn eigen state-of-the-art systeem trainen voor het beantwoorden van vragen.

Google geeft aan dat BERT helpt de nuances en context van woorden in zoekopdrachten beter te begrijpen en die zoekopdrachten beter te matchen met relevantere resultaten. Deze doorbraak is het resultaat van Google-onderzoek naar transformers: modellen die woorden verwerken in relatie tot alle andere woorden in een zin.

BERT-modellen kunnen daarom de volledige context van een woord in overweging nemen door te kijken naar de woorden die ervoor en erna komen – vooral handig om de intentie achter zoekopdrachten te begrijpen.

Hieronder een paar voorbeelden die Google zelf heeft gegeven:

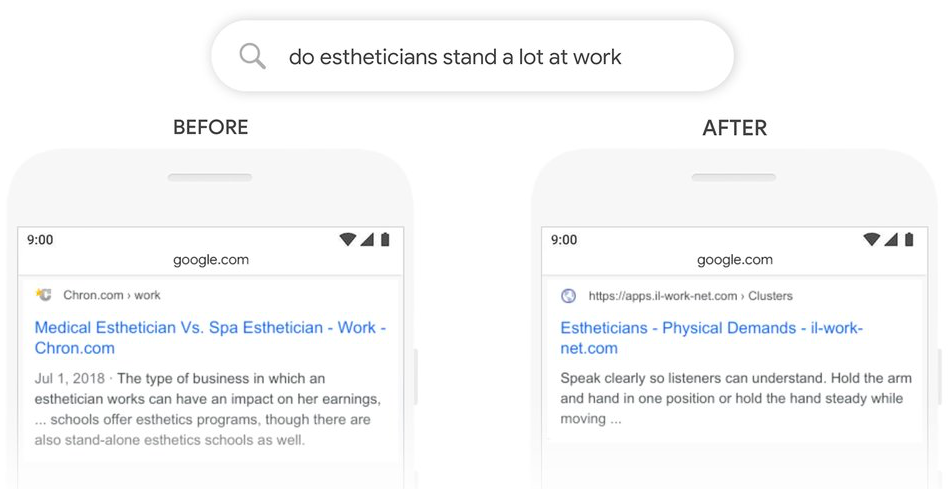

Voorbeeld 1: Staan schoonheidsspecialisten veel op het werk

Laten we eens kijken naar een zoekopdracht: “staan schoonheidsspecialisten veel op het werk.” Vroeger koos Google voor het matchen van trefwoorden, waarbij de term “stand-alone” in het resultaat overeenkwam met het woord “stand” in de query. Maar dat is niet het juiste gebruik van het woord “staan” in deze context. De BERT-modellen begrijpen daarentegen dat ‘staan’ verband houdt met het concept van de fysieke eisen van een baan en laat een veel nuttiger resultaat zien.

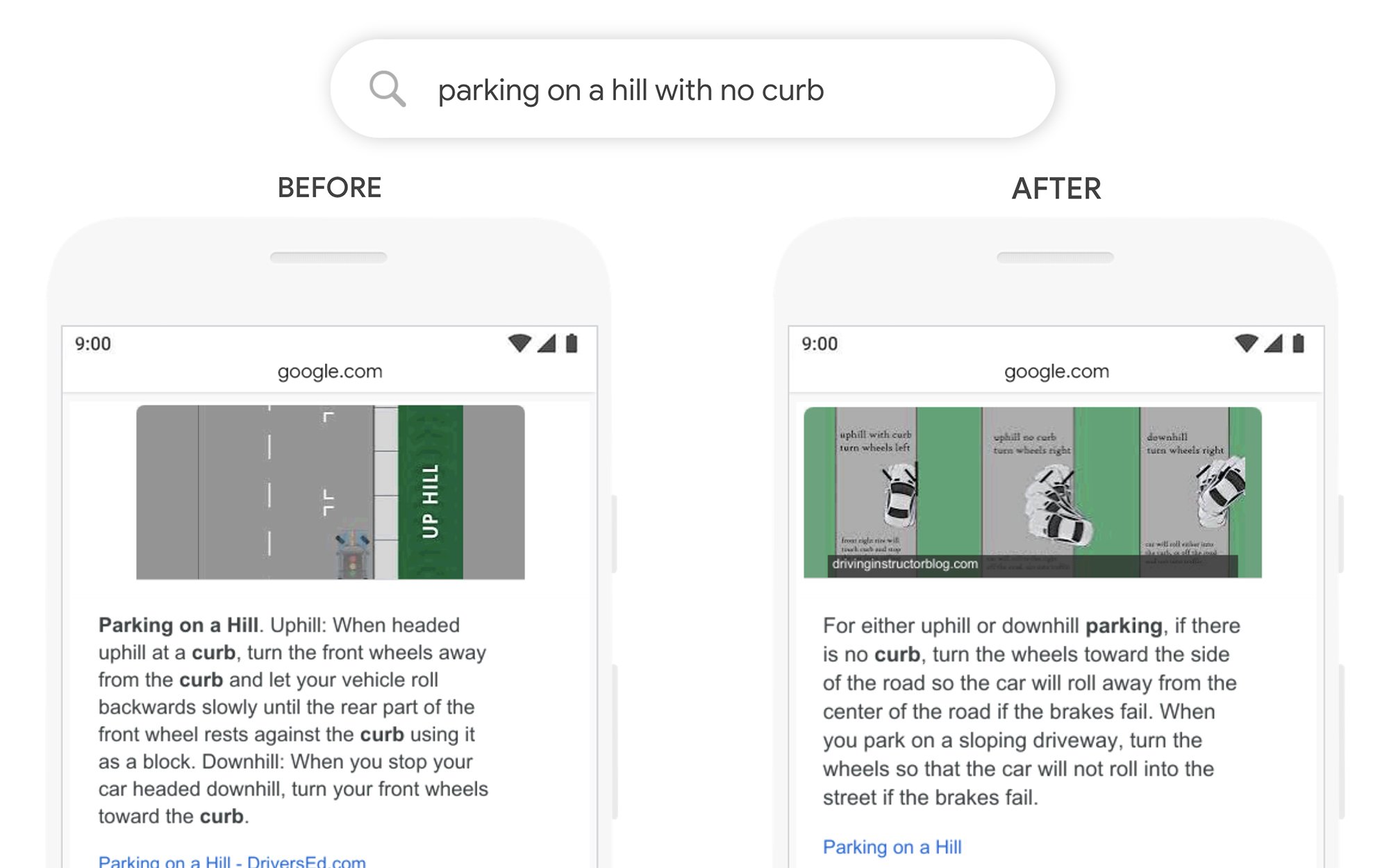

Voorbeeld 2: Parkeren op een heuvel zonder stoeprand

In het verleden zou een query als deze Google verwarren. Er werd te veel belang gehecht aan het woord “curb” (stoeprand) en het woord “no” werd genegeerd, niet begrijpend hoe kritisch dat woord was om op de juiste manier op deze query te reageren. Het oude resultaat zou resultaten retourneren voor parkeren op een heuvel mét een stoeprand!

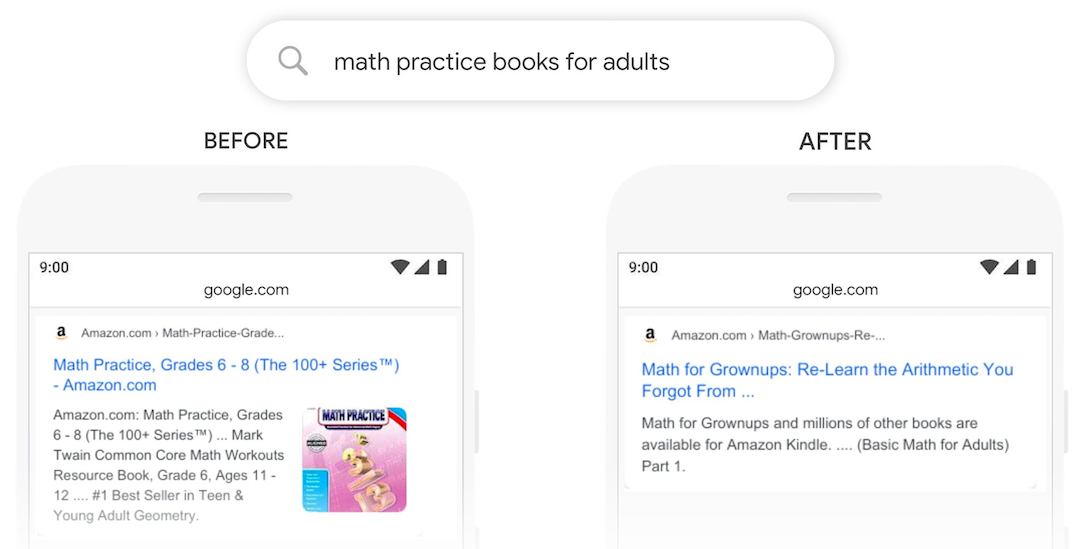

Voorbeeld 3: oefenboeken wiskunde voor volwassenen

Hoewel het oude resultaat een boek bevatte in de categorie ‘Jongvolwassene’, kan BERT beter begrijpen dat ‘Adult’ buiten zijn context wordt gekoppeld en een nuttiger resultaat uitkiezen.

Featured snippets en voice search

Deze update heeft ook invloed op featured snippets en daarmee voice search. Een featured snippet is een uitgelicht zoekresultaat dat een beknopt en direct antwoord geeft op een zoekvraag. Deze snippets kiest Google in 70% van de gevallen voor het weergeven van een antwoord bij voice search en Google heeft aangegeven dat BERT wereldwijd, in alle talen, voor featured snippets gaat gebruiken.

BERT kan long tail zoektermen / vragen beter begrijpen dan voorheen het geval was en zal dus ook een beter voice antwoord gaan geven. Waar we onszelf bij zoekopdrachten hebben aangeleerd onze zoekvragen in steekwoorden op te schrijven, is dit bij voice search niet het geval. Hier gebruiken we lopende zinnen en spreektaal. Dit is de achilleshiel voor de huidige algoritmes. Met de BERT toevoeging gaat Google ook grote stappen zetten om “gesproken” tekst te doorgronden en hier een passende reactie op geven. Dit gaat er voor zorgen dat voice search sneller volwassen wordt en meer gebruikt gaat worden.

Wat gaan we merken?

De update wordt nu uitgerold voor Engelstalige zoekopdrachten en zal op termijn uitgebreid worden naar andere talen. Zoek je zelf niet vaak in het Engels of heb je geen website met Engelse resultaten, dan zul je er nog niet direct veel van merken.

Wat is de impact op SEO?

Voor BERT was er al RankBrain, wat de eerste kunstmatige intelligentie methode was van Google voor het begrijpen van zoekopdrachten en stamt al uit 2015. RankBrain onderzoekt zowel zoekopdrachten als de inhoud van webpagina’s in de index van Google, om beter te begrijpen wat de betekenis van de woorden is. BERT is een aanvullende methode voor het begrijpen van inhoud en zoekopdrachten en vervangt daarmee RankBrain niet.

Google heeft eerder aangegeven dat het geen zin heeft om specifieke SEO strategieën op deze Google updates los te laten. Als je een website beheert of teksten schrijft met een gebruiker in het achterhoofd, dan ga je automatisch beter ranken met deze updates.

Maar als we ons daarin verdiepen, dan is er voor SEO nog genoeg werk te doen. Het wordt nog belangrijker om content voor echte mensen te schrijven en dat betekent bijvoorbeeld dat productoverzicht pagina’s echte volzinnen dienen te bevatten en niet enkel paar losse zoekwoorden en productafbeeldingen. Er dienen nog steeds duidelijke structuren in websites te zitten en bovenal moeten ongestructureerde gegevens worden omgezet in semi-gestructureerde gegevens.

Deze BERT update is een kans voor je website om meer bezoekers te krijgen op content die meer gericht is geschreven en goed georganiseerd is.

Search is geen opgelost probleem

Google Search vice president Pandu Nayak: “Zelfs met BERT hebben we het niet altijd goed. Als je zoekt naar ‘welke staat is ten zuiden van Nebraska’, dan is de beste gok van BERT een gemeente met de naam ‘Zuid-Nebraska’. Het begrijpen van taal blijft een voortdurende uitdaging en het houdt ons gemotiveerd om het zoeken te blijven verbeteren. We worden altijd beter en werken eraan om de betekenis te vinden in – en de meest nuttige informatie voor – elke vraag die u ons toestuurt.”

Plaats een reactie

Uw e-mailadres wordt niet op de site getoond