A/B-tests prioriteren met frameworks

Stel, je bent vol goede moed gestart of bezig met de conversie-optimalisatie van je website of webshop. Je hebt je data geanalyseerd, het bezoekersgedrag op knelpunten gemeten en geanalyseerd, misschien ook polls of enquêtes onder bezoekers en klanten gehouden, haarscherpe hypotheses opgesteld, en nu ben je klaar voor het A/B-testen van die hypotheses. Maar je lijstje met A/B-tests is nogal lang geworden… Hoe bepaal je dan met welke A/B-tests je begint? Hoe zorg je er dan voor dat je snel resultaten van je conversie optimalisatie inspanningen ziet?

Dat doe je door je A/B-tests op de juiste manier te prioriteren. Wat vaak niet gebeurt: het niet prioriteren van A/B-tests is één van de meest voorkomende A/B-test beginnersfouten. Door gefundeerde prioriteiten te stellen voorkom je dat je kostbare tijd, traffic en andere middelen verspilt.

Frameworks voor het prioriteren van A/B-tests

Om je A/B-tests te prioriteren zijn er een aantal zogenaamde frameworks beschikbaar. De belangrijkste A/B-test frameworks vind je hieronder.

PIE framework

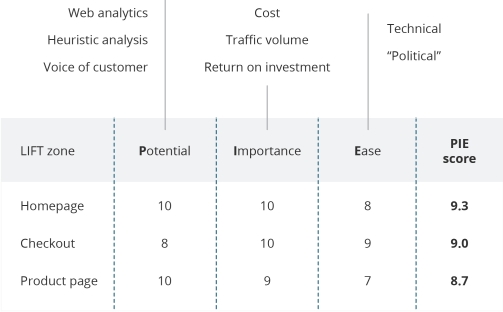

Het PIE framework is een priorizatiemodel waarmee een A/B-test een score tussen 0 en 10 krijgt op basis van P(otential), I(mportance) en E(ase). Hierbij is Potential de potentiële uplift in conversie, Importance de mate van belangrijkheid van de te testen pagina of onderdeel van je website, en Ease het gemak waarmee zowel de A/B-test kan worden opgezet als een winnende testvariant in de bestaande website kan worden doorgevoerd.

In de praktijk kunnen Potential, Importance en Ease nogal met elkaar wringen. Zo heeft bijvoorbeeld een aanpassing van (een deel van) de checkout van een webshop vaak een hoge potentiële uplift, is dit zeer belangrijk voor de conversie van de webshop, maar is dit niet altijd gemakkelijk A/B te testen zonder ingrijpende wijzigingen in de checkout.

TIR Model

Het TIR model werkt op dezelfde manier, hierbij geef je echter per A/B-test scores aan T(ime), I(mpact) en R(esources). Hierbij is Time de tijd die het kost om zowel de A/B-test op te zetten en uit te voeren als een winnende testvariant door te voeren. Impact is de potentiële impact die deze verbetering zal hebben op zowel de conversie als andere KPI’s zoals usability (dus deels vergelijkbaar met Potential bij het PIE framework). Resources zijn de benodigde mensen en middelen voor zowel het opzetten van de A/B-test als het doorvoeren van een winnende testvariant.

Monetate Model

Bij het model van Monetate worden scores gegeven aan drie elementen: de moeilijkheid (of het gemak) waarmee zowel de A/B-test kan worden opgezet als een winnende testvariant in de bestaande website kan worden doorgevoerd, de creativiteit die nodig is voor de A/B-test (denk aan bijvoorbeeld het design van een banner of call-to-action), en de potentiële impact van de A/B test op de conversie. Het Monetate model lijkt dus veel op het PIE framework.

Hotwire’s puntenmodel

Het puntenmodel van Hotwire combineert elementen van de bovenstaande modellen en groepeert die in Value en Effort. De groep Value bevat de elementen Reach (hoeveel bezoekers zullen met deze A/B test worden bereikt?), Lift (de potentiele uplift in conversie) en Strategic Fit (de mate waarin de test past in de business strategie). De groep Effort bevat de elementen Creative (zie het Monetate Model), Development (de mate waarin ICT of web development nodig is), en Coördination (idem, maar dan voor de mate van coördinatie en aansturing).

Het sterke aan Hotwire’s puntenmodel is het element Strategic Fit. Uiteindelijk moet de conversie-optimalisatie als geheel, en daarbinnen de A/B-tests, bijdragen aan de strategie en doelstellingen van de organisatie. En dat wordt in de dagelijkse praktijk nog wel eens vergeten…

Het ideale A/B-test framework

Je raadt het al, dat bestaat niet. Het framework dat de ene organisatie met succes gebruikt om zijn A/B-tests te prioriteren, werkt minder goed binnen de andere organisatie. Dat heeft vooral te maken met de werkwijze en cultuur binnen een organisatie. Uiteindelijk kies je het framework wat goed werkt voor jouw organisatie, of stel je een framework samen wat voor je organisatie ideaal is.

Zelf scoren en prioriteren wij A/B-tests meestal aan de hand van de volgende elementen:

- Strategie – de mate waarin de test past in de business strategie en doelstellingen;

- Potentiële impact – het bereik en de potentiële uplift in conversie;

- Tijd en timing – de tijd die nodig is om de test uit te voeren en het ideale moment daarvoor;

- Gemak – het gemak (of beter gezegd, de moeilijkheid) om de test op te zetten en uit te voeren en een winnend resultaat door te voeren, zowel technisch als voor wat betreft de hiervoor benodigde mensen en middelen.

*) Dit artikel is gebaseerd op het artikel A/B tests prioriteren met frameworks

Plaats een reactie

Uw e-mailadres wordt niet op de site getoond