Testevaluatie en -optimalisatie: Hoe om te gaan met testresultaten

Een verandering voor een webshop of website kan na evaluatie een succes blijken, of niet. In beide gevallen eindigt webshop-optimalisatie niet, want ook uit een negatief testresultaat kunnen belangrijke inzichten gehaald worden. Dit artikel gaat in op welke overwegingen er spelen na het resultaat van een A/B-test en wat de vervolgstappen zijn. Daarnaast wordt uitgelegd hoe webshop-optimalisatie door middel van een optimalisatie-cultuur naar een hoger niveau getild kan worden.

Stel…

Er is een rode bestelknop in de winkelmand van je webshop. Je test deze knop tegenover een groene, omdat je denkt dat groen een positiever gevoel bij je bezoekers oproept en daardoor de conversie verhoogt. Er zijn dan twee scenario’s:

- De groene knop presteert beter dan de rode knop, je test was een succes.

- De rode knop presteert beter dan de groene knop of er is geen verschil tussen beide knoppen, je test was geen succes.

Je hoopt natuurlijk altijd op een succesvolle test die je hypothese bevestigt en voor een verbetering zorgt. Als dit het geval is, stop je dan met testen? En als je test onverhoopt toch geen succes is, gooi je dan de hypothese direct overboord? Helaas zien we vaak dat deze werkwijze nog de status quo binnen bedrijven is die bezig zijn met webshop-optimalisatie. Om echter de juiste conclusies te kunnen trekken en relevante vervolgstappen te bepalen, moet een aantal diepgaandere vragen beantwoord worden, zoals:

- Waarom was de test geen succes? Kan het niet ook zijn dat groen wel degelijk beter werkt dan rood, maar dat je nog niet de juiste tint hebt gevonden?

- In het geval dat groen wel wint: is dat dan de beste kleur? Of zal een andere kleur nóg beter werken?

- Waarom was de test wél een succes? Een rode button kan misschien wel een hogere conversie opleveren dan een groene button, maar wat leer je hieruit?

- Is de gerealiseerde conversiestijging de hoogst haalbare optimalisatie en wanneer stop je met tweaken en tunen?

Evaluatie

Om deze vragen te beantwoorden is een grondige evaluatie na een A/B-test cruciaal. Hierin wordt in eerste instantie gekeken of het beoogde doel bereikt is en of de hypothese bevestigd wordt of niet.

Bij de evaluatie van een negatief testresultaat is de grootste valkuil om te concluderen dat een test waarin geen conversieverbetering is gerealiseerd, een mislukking is. Maar door ook te achterhalen waarom de hypothese niet bevestigd kon worden kom je meer te weten over je bezoekers en kun je waardevolle ideeën opdoen voor relevante vervolgstappen.

Bij de evaluatie van positieve testresultaten daarentegen is de grootste valkuil om gewoon te stoppen met testen zonder ook maar enige aandacht te besteden aan de testresultaten. Want ook hier geldt: door te achterhalen waarom een bepaald resultaat behaald werd, te kijken of er nog meer verbeterd kan worden en wat de logische vervolgstappen zijn kan je waardevolle ideeën opdoen voor een nog succesvollere vervolgtest. Het is dan ook raadzaam om minimaal één vervolgtest uit te voeren die gebaseerd is op de testresultaten van de vorige test.

Mogelijke vervolgstappen

Afhankelijk van de testresultaten kunnen relevante vervolgstappen worden uitgevoerd. Deze vervolgstappen kunnen er enerzijds toe dienen om het waarom achter een testresultaat te achterhalen en anderzijds om, gebaseerd op het resultaat, een vervolgtest inclusief hypothese uit te werken.

Bij een A/B-test zijn er in eerste instantie talrijke webstatistieken beschikbaar waarin je naar relevante gedragingen en veranderingen in gedrag kan kijken, ook buiten de hoofd KPI’s om. Door daarnaast te onderzoeken of deze veranderingen een logisch verband met elkaar houden en door relevante groepen te segmenteren wordt inzichtelijk of een wijziging bij verschillende groepen wel (of juist geen) significant effect laat zien.

Voorbeeld uit de praktijk

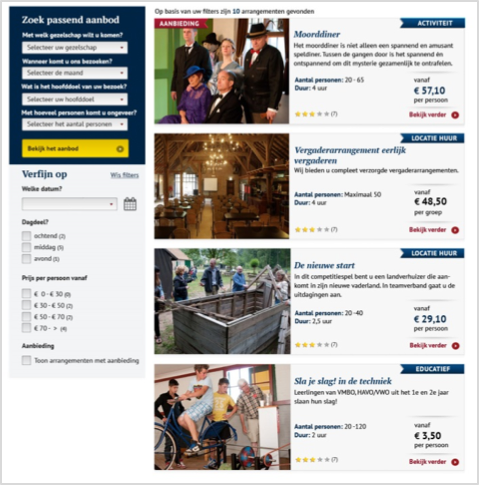

Uit een analyse bleek dat veel bezoekers van de website van het openluchtmuseum afhaakten op de overzichtspagina van groepsarrangementen en dat zij niet verder gingen naar een arrangementdetail-pagina. Uit click- en heatmaps bleek dat bezoekers zich moeilijk konden focussen op de overzichtspagina. Terwijl de hypothese was dat het toevoegen van filters en een nieuwe rangschikking (onder elkaar in plaats van naast elkaar) de pagina vele malen gebruiksvriendelijker maakt, leek de verandering aanvankelijk geen succes: optimalisatie van de overzichtspagina leidde tegen de verwachting in juist tot nóg minder doorstroom naar de detail-pagina.

Na:

Verder op de resultaten inzoomend werd echter inzichtelijk dat de wijzigingen géén negatief effect hadden op het aantal conversies aan het einde van de funnel. Absoluut gezien leverde de nieuwe variant zelfs enkele contact- en offerte-aanvragen meer op. Een mogelijke verklaring voor het resultaat was dat, omdat bezoekers sneller een overzicht hebben van de gewenste producten, ze minder heen en weer moeten klikken om tot een relevante keuze te komen.

Daarnaast bleek uit een analyse van muisbewegingen dat bezoekers filterselecties maakten die geen of weinig resultaten opleverden. De logische vervolgstap was dan ook om te gaan monitoren welke filtercombinaties door bezoekers worden gemaakt die geen of weinig resultaten opleveren en om ervoor te zorgen dat het aanbod hierop aansluit en/of er alternatieven worden geboden.

Een usability test is een ander mogelijk voorbeeld voor het evalueren van het resultaat van een doorgevoerde A/B-test: waar A/B-tests vooral antwoord geven op kwantitatieve vragen, richt een usability-test zich meer op het waarom. Daarom is een usability test een waardevolle aanvulling die meer diepgang oplevert. Dit is voornamelijk interessant als de mogelijke verandering kostbare en verreikende gevolgen met zich mee brengt. En ten slotte is natuurlijk in principe elke analysemethode die in de analysefase wordt gebruikt ook als evaluerende methode te gebruiken.

Bij het uitwerken van een vervolgtest, inclusief nieuwe hypothese, neem je dus de learnings uit de evaluatie van de vorige test altijd mee. Hierdoor kom je stapsgewijs tot een steeds hogere conversie omdat je relevante vervolgtests uitvoert die opbouwen op de vorige resultaten. Een conversie van 100 procent bestaat niet, maar je komt er met elke test iets dichterbij en door een structurele evaluatie in te zetten weet je zeker dat je ook dichtbij de behoeften en het gedrag van je bezoekers blijft.

Optimalisatiecultuur

Onafhankelijk van of je test wel of geen succes was, helpt het enorm om je learnings te documenteren en te delen met andere teams en afdelingen. Door een organisatie brede- en data driven aanpak te hanteren die bij de unieke behoefte van het bedrijf, de webshop en natuurlijk de bezoekers past wordt webshop-optimalisatie naar een hoger niveau getild en weet je zeker dat je testresultaten toegevoegde waarde voor de organisatie hebben. Deze aanpak wordt ook optimalisatiecultuur genoemd.

Bij het creëren van een optimalisatiecultuur binnen een bedrijf helpt het om naar aanleiding van de evaluatie testresultaten te delen, een dashboard met alle resultaten uit het verleden bij te houden en een speelse manier te vinden om het interesse aan webshop-optimalisatie organisatie breed te stimuleren, bijvoorbeeld in de vorm van een quiz (zie voorbeeld van WhichTestWon). Een vast testritme zorgt daarnaast voor extra betrokkenheid in het team en de hele organisatie omdat er regelmatig concrete resultaten en conclusies gerapporteerd kunnen worden. Een A/B-test kan daardoor nooit falen, maar levert altijd inzichten op in wat wel en wat niet werkt. Testresultaten inspireren op die manier andere teams en leiden weer tot nieuwe hypothesen en testideeën.

Bij een optimalisatiecultuur gaat het dus vooral om de betrokkenheid van verschillende mensen uit de organisatie. Dit houdt in dat de optimalisatie niet stopt na een A/B-test, maar dat een continue en dynamische optimalisatiecyclus gehanteerd wordt, waarin een groter aantal A/B-tests uitgevoerd wordt die telkens gebaseerd zijn op evaluaties uit eerdere tests, idealiter met een iteratieve aanpak in een multidisciplinair team. Uit recent onderzoek blijkt dan ook dat bedrijven met een optimalisatiecultuur een gemiddelde conversie van 3,6 procent hebben, terwijl deze bij minder volwassen bedrijven bij slechts 1,8 procent ligt.

Conclusie

Webshopoptimalisatie is een continu en dynamisch proces. Daarom is het belangrijk om te blijven analyseren, te testen en vooral te evalueren. Een conversie van 100 procent bestaat niet. Maar je komt er met elke test iets dichterbij door het testresultaat goed te evalueren om er zo veel mogelijk van te leren, er vervolgstappen op te baseren en de learnings mee te nemen voor een volgende test. Daardoor weet je zeker dat je dichtbij de behoeften en het gedrag van je bezoekers blijft. Daarnaast helpt een optimalisatiecultuur je om het draagvlak voor testen binnen je organisatie te vergroten en de juiste keuzes te maken.

Plaats een reactie

Uw e-mailadres wordt niet op de site getoond