De drie pijlers van verantwoordelijke AI: hoe te voldoen aan de Europese AI-wet

De Europese Unie heeft haar AI-wet geïntroduceerd. Wat houdt die in en hoe vertalen we de eisen die daarin zijn vastgelegd naar concrete principes en ijkpunten als je met AI werkt?

Met de recente introductie van de nieuwe Europese AI-wet komt er een nieuwe focus op de ethische en verantwoordelijke toepassing van algoritmes. De aanleiding is de opkomst van kunstmatige intelligentie (AI) en Machine Learning, maar de wetgeving heeft betrekking op alle systemen die beslissingen nemen. De wet benoemt (onder andere) eisen die worden gesteld aan de organisatie die de AI toepast, die “high-risk” worden genoemd. Dat zijn eigenlijk alle implementaties waarin met AI beslissingen worden genomen met directe invloed op het menselijke maatschappelijk leven. Dit kan gaan van medische toepassingen, tot het beoordelen van CV’s in een sollicitatieproces of het bepalen van een WOZ-waarde.

We weten nog niet precies hoe deze wet in ieder land in Europa vorm gaat krijgen en wie toezicht op deze wet gaat houden. Er is beslist nog onzekerheid, maar sinds 13 maart 2024 (de datum waarop het Europees Parlement instemde met de wet) weten we wel welke principes zullen gaan werken. Ook weten we dat de boetes zullen variëren van anderhalf tot zeven procent van de omzet of zeven-en-een-half miljoen vijfendertig miljoen euro van de organisatie die AI toepast, afhankelijk van grootte van de organisatie en de aard van de overtreding.

Wie de verantwoordelijke is, is in dit kader natuurlijk zeer belangrijk. Een voorbeeld: als een gemeente een organisatie inhuurt om met AI een WOZ-waarde te bepalen, is de gemeente als toepasser verantwoordelijk.

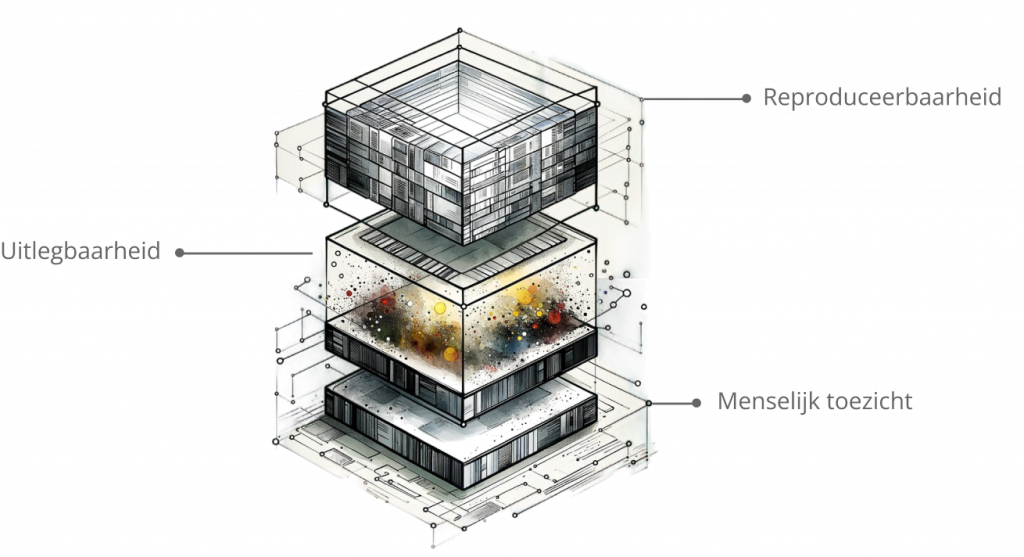

Drie principes

Er zijn drie cruciale principes die rechtstreeks uit deze regelgeving voortvloeien en vereist zijn voor het gebruik van Machine Learning in deze gevallen: reproduceerbaarheid, uitlegbaarheid, en menselijk toezicht. Deze principes vormen de kern van een ethische AI-toepassing die voldoet aan deze strengste normen van de nieuwe Europese wetgeving, en benadrukken het belang van transparantie en verantwoording in AI-systemen.

Daarbij lijkt de term AI-systeem heel futuristisch, maar onder deze definitie vallen veel bestaande operationele systemen. Bijvoorbeeld geautomatiseerde beslissingen (businesslogica) inzake zorgkosten, boetes, visumaanvragen, transactiemonitoring, etc. Een groeiende lijst van zaken die onder de definitie ‘AI-systeem’ vallen is opgenomen in Annex 3 van de wet.

Het gaat er dus niet om hoe geavanceerd het algoritme is, maar vooral om de consistentie, de uitlegbaarheid naar eindgebruikers, en de menselijke controle op het model. Laten we eens inzoomen op deze drie kernprincipes.

Principe 1 – Reproduceerbaarheid

Reproduceerbaarheid verzekert dat AI-systemen consistente en herhaalbare resultaten kunnen leveren, een fundamentele eis binnen de AI-wet om vertrouwen en betrouwbaarheid in AI-toepassingen te garanderen. Op deze manier is gewaarborgd dat elke beslissing in het AI-systeem transparant te traceren is. Daarbij geldt, makkelijk gezegd, dat een fout nog steeds gemaakt kan worden, maar dat het mogelijk is om aan te geven wáár de fout gemaakt is. Dit is vooral cruciaal in kritieke sectoren zoals gezondheidszorg en financiën, waar inconsistente beslissingen ernstige gevolgen kunnen hebben. Denk aan het mechanisme bij de toeslagenaffaire.

Dat er fouten worden gemaakt is al onwenselijk, maar dat we niet kunnen reproduceren welke fouten dat zijn is onaanvaardbaar. Dit betekent ook dat logging vereist is: wanneer is het ‘resultaat’ gemaakt? Welke versie van een-AI model is gebruikt om tot een beslissing te komen? Om resultaten te kunnen reproduceren is dit soort automatische logging essentieel.

- De vraag die je als AI gebruiker dus moet stellen is:

als ik deze vraag nog een keer stel aan dit model, krijg ik dan hetzelfde antwoord? Als het antwoord op die vraag ‘nee’ is, dan is er werk aan de winkel.

Principe 2 – Uitlegbaarheid

Uitlegbaarheid, of ‘Explainable AI’ (vaak afgekort als XAI), benadrukt het vermogen van AI om de logica achter beslissingen inzichtelijk te maken voor eindgebruikers. Dit principe ondersteunt direct de eisen van de Europese AI Act voor transparantie en begrijpelijkheid, waardoor gebruikers en toezichthouders (zie principe 3 hieronder) de werking van AI-systemen kunnen beoordelen en vertrouwen.

Door gebruik te maken van XAI-technieken kan aangetoond worden welke variabelen invloed hebben gehad op de uitkomst van een beslissing. Met de invoering van de AI-wet wordt XAI een vereiste voor alle implementaties met een hoog risico. De AI als ‘zwarte doos’ wordt voor alle high-risk beslissingen simpelweg niet geaccepteerd binnen deze wetgeving.

Ook voor de invoering van de AI-wet had de overheid al de plicht om inzage en uitleg te geven over beslissingen die worden gemaakt ten aanzien van burgers (bijvoorbeeld de WOZ-waarde of boetes). Op het moment dat deze beslissing (deels) op AI berust, is in de AI-wet bepaald dat met name deze uitleg onverminderd blijft gelden. Voor AI-implementaties met een hoog risico geldt zelfs dat deze een hoger niveau moet hebben dan in de huidige situatie.

- De vraag die een (potentiële) AI gebruiker hier moet stellen is:

kan het gebruikte systeem een beslissing uitleggen zodanig dat de ontvanger deze ook snapt? Of als ik de huidige beslissing ga automatiseren, kan ik het dan ook nog altijd uitleggen aan de ontvanger of eindgebruiker? Zo niet, dan is er werk aan de winkel om de beslissing uitlegbaar te maken en/of de uitkomst beter uit te leggen.

Principe 3 – Menselijk toezicht

Menselijk toezicht garandeert dat, ondanks de autonomie van AI-systemen, menselijke tussenkomst mogelijk blijft om ethische normen en maatschappelijke waarden te handhaven. Dit principe erkent de onvervangbare waarde van menselijke discretie en beoordeling, vooral in complexe of gevoelige situaties.

In de praktijk betekent dit dat er, door inhoudelijk experts, steekproefsgewijs, maar wel voortdurend (dus elke dag) controles moeten worden uitgeoverd op de uitkomst van het model. De feedback daarvan zou gebruikt moeten worden bij het steeds verder verbeteren van het model. Daarbij wordt de grootte en de frequentie van die steekproef onder andere bepaald door hoe belangrijk het proces dat geautomatiseerd wordt is. Bij te grote afwijkingen moet een model dan onmiddellijk automatisch uitgezet kunnen worden. Dit is van groot belang, omdat zowel het AI-model als de onderliggende data over de tijd veranderen. Een AI-model is dus altijd beperkt houdbaar en moet continu worden bijgesteld.

Deze feedbackcirkel zorgt er ook voor dat bias (bijvoorbeeld onbewuste vooroordelen of discriminatie) onder controle blijft. Zulke ongewenste uitkomsten komen namelijk naar voren uit de uitleg van het model en kunnen dan bijgestuurd worden door menselijke feedback, waardoor het model ook in onverwachte situaties snel gecorrigeerd kan worden door eindgebruikers.

Een model zou bij een beslissing een betrouwbaarheidsniveau moeten kunnen aangeven. Als een model te weinig data heeft om een bepaalde beslissing te maken, moet een beslissing naar een expert gestuurd kunnen worden. Een voorbeeld: een model kan een WOZ-waarde niet betrouwbaar genoeg bepalen omdat het voor een bepaald huis geen goed vergelijkingsmateriaal heeft. Dan moet die beslissing dus naar een expert die dat wel kan. Deze werkwijze is juist een sterkte, geen fout van een model.

- De vraag die een AI gebruiker hier moet stellen is:

worden de door het model/algoritme gegenereerde uitkomsten regelmatig (en liefst continu) gecheckt? Wordt de input van deze experts weer gebruikt bij het verder trainen van een model? Is het antwoord nee, dan is er weer aan de winkel.

Evenwicht

Door de genoemde drie principes te integreren, benadrukt deze benadering van de AI-ontwikkeling en -implementatie een evenwicht tussen het benutten van technologische vooruitgang en het waarborgen van de ethische integriteit van deze systemen. Daarmee is niet gezegd dat alles al precies duidelijk en afgedekt is: het is een kwestie van interpretatie.

De Europese AI-wet zet hiermee de toon voor een toekomst waarin AI niet alleen innovatief en krachtig is, maar ook verantwoordelijk en in lijn met fundamentele menselijke waarden en rechten. Deze aanpak stimuleert een verantwoordelijke ontwikkeling van AI-technologieën die het menselijk welzijn centraal stellen, met systemen die transparant, eerlijk, en altijd onderworpen zijn aan menselijke beoordeling en correctie.

Over de auteur: Joost de Valk is Partner bij Emilia Capital en Bastiaan van de Rakt is co-founder van Deeploy.

Gerelateerde opleiding

Deel dit bericht

Plaats een reactie

Uw e-mailadres wordt niet op de site getoond

1 Reactie

Joel - Aithenticate

Wat een goed stuk Joost! Wat denk je van AI Labbeling? Ik heb een WordPress Plugin gemaakt die dat heel makkelijk maakt. Je kiest bij elke post/page of het met AI is gemaakt of Human Crafted. De disclosure wordt dan automatisch aan het einde van de pagina toegevoegd! Ik ben erg benieuwd wat je van het idee vind! (Aithenticate.org)