27 fouten om te voorkomen tijdens A/B-testen (3/3)

Na veel enthousiasme en een gevoel van vooruitgang door AB-testen volgt vaak de grote deceptie. In het beste geval waren er een aantal testen met 5 tot 30 procent verbetering, maar ondanks dat beweegt de conversielijn in Google Analytics niet echt omhoog. Met de 27 valkuilen van AB-testen in deze serie kun je kijken of je organisatie conversie optimalisatie wel op de juiste manier benadert. Vandaag deel drie.

Deel II gaat in zijn geheel over het testen van de verkeerde dingen, de meest onvergeeflijke fout bij AB-testen. Deel I of deel II gemist? Bekijk ze hier: Deel I en Deel II.

Deel III: Verkeerde uitvoering & conclusies testen

- Je data klopt niet

Gebruik je ‘click tracking’ als basis voor je conversiedoelen in Optimizely of VWO? En heb je deze conversies al eens vergeleken het pageview goal van die volgende pagina in je check-out?

Grote kans dat de click tracking conversies lager zijn dan de pageviews. Vaak is Internet Explorer de boosdoener.

Als je maar 90 procent van de daadwerkelijke conversies naar de volgende funnelstap meet, duurt je experiment al snel 15 tot 50 procent langer (bij een conversieverhoging van 10 procent).

Kies je conversie track methode zorgvuldig en vergelijk deze met andere bronnen.

- Je vergeet de (ervaren) laadtijd van je variatie

Zelfs als je data klopt kan het zijn dat je toch appels met peren aan het vergelijken bent. Tools als Optimizely en VWO hebben wel degelijk invloed op de laadtijd.

In het geval van Zelf.nl leidde een 0.9 seconde snellere pagina tot 48 procent meer conversie. Als je variant dus langzamer zou deze wel eens direct op 1-0 achterstand kunnen beginnen ten op zichte van je normale pagina.

Controleer minimaal of je test last heeft van het bekende ‘knipper effect’. Dit zorgt er namelijk voor dat de ervaren laadtijd langer wordt en je conversies verliest.

- Je optimaliseert voor de verkeerde mensen

Bezoekers uit social media en e-mailcampagnes hebben een andere mindset dan die van andere kanalen en komt vaak in golven naar je site toe. Je kiest immers zelf wanneer je gaat deze campagnes live zet. Dit verkeer verdient een aparte benadering, maar ‘vervuilt’ ook je experimenten gericht op de andere kanalen.

Idealiter ga je uiteindelijk aparte testen opzetten voor deze doelgroepen.

- Je test moet langer lopen. Ja, nog langer.

AB-test software oplossingen die alleen ‘significantie’ aangeven vertellen het halve verhaal.

95 procent significantie wil alleen maar zeggen dat er een 5 procent kans is dat je bijvoorbeeld 7 procent verbetering meet, terwijl er eigenlijk geen verschil is.

Het doel is uiteindelijk om zeker genoeg te zijn dat die 7 procent inderdaad betekent dat je variant het beter doet. Daar komt het begrip ‘power’ om te hoek kijken.

Bereken daarom altijd van te voren de sample size die je nodig hebt op basis van 95 procent significantie en 80 procent power. Power is de andere helft van het verhaal dat AB-test software partijen altijd lijken te negeren.

- Je test loopt geen volledige weken

Conversiepercentages op verschillende dagen van de week zijn niet te vergelijken.

Test dus altijd volle weken om geen vertekend beeld te krijgen.

- Je meet niet alle conversiepunten

Iedereen zou 10 euro betalen voor een klant die in zijn 1e order 100 euro oplevert. in de praktijk wordt er vaak gekozen om niet deze 100 euro te meten, maar het aantal keren dat bezoekers doorklikken naar een vervolgpagina. Hierbij wordt er vanuit gegaan dat een hogere doorklikratio ook goed is voor de eindconversie en dus meer omzet oplevert.

De reden voor deze keuze is dat een experiment hierdoor veel sneller afgerond kan worden. Dat kan een prima pragmatische keuze zijn.

Maak echter niet de fout om de eindconversie helemaal niet te meten. Een hogere doorklik ratio kan gepaard gaan met een lagere omzet, doordat mensen ‘te snel’ doorklikken zonder je waarde propositie goed te hebben gezien.

- Je test 2 aanpassingen tegelijkertijd

Dit is een fout als je niet bewust hier een keuze voor maakt. Het probleem van 2 aanpassingen tegelijkertijd testen is dat als je geen verbetering meet je niet weet wat de aanpassingen apart van elkaar voor effect zouden hebben.

Kies er in de basis voor om veranderingen te isoleren, of juist een hele radicale wijziging te testen om zo snel mogelijk een sterke conversieverbetering te bereiken.

- Je vergeet te segmenteren bij je testevaluatie

Alle verkeersbronnen sturen bezoekers die andere karakteristieken hebben en dus anders kunnen reageren op veranderingen. Controleer dus altijd wat het effect op deze segmenten is. Het zou zonde zijn om een 10 procent verbetering op SEA traffic te laten liggen, omdat je alleen naar het totaal gemiddelde kijkt.

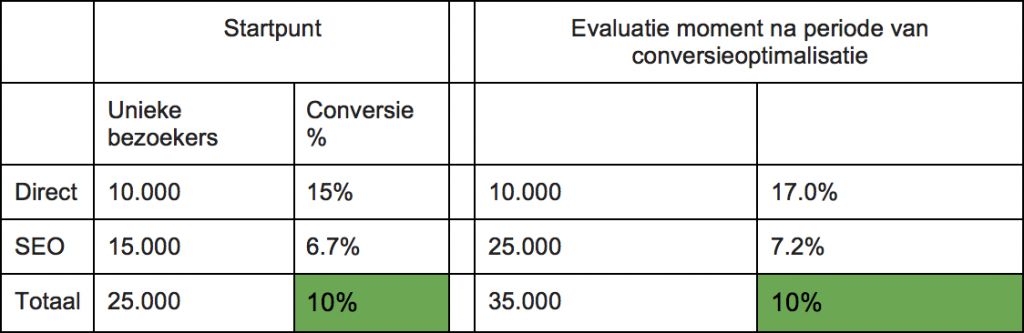

- Je kijkt naar de conversietrend op al het verkeer samen

Uiteindelijk wil je dat je gemiddelde conversie percentage in Google Analytics of Omniture omhoog gaat. Maar ook hier moet je segmenteren.

Als je dat niet doet kan het zijn dat je schrikt van een dalende conversietrend, terwijl je juist heel blij moet zijn.

Dit kun je zien in dit eenvoudige voorbeeld van een fictieve site met bezoekers uit maar twee kanalen. Het conversiepercentage is sterk gestegen voor het directe verkeer en het organische verkeer (SEO). Toch is het totale conversiepercentage niet veranderd.

De reden is hier snel duidelijk: Het minder converterende SEO-kanaal heeft meer bezoekers binnengebracht. Kennelijk heeft je SEO-team of -bureau goed werk gedaan waardoor je nu zou kunnen denken dat je conversie optimalisatie inspanningen voor niets zijn geweest.

Zeer logisch, maar toch gaan er altijd mensen zijn die schrikken van een dalende lijn, omdat ze naar een totaal gemiddelde kijken wat eigenlijk niets zegt.

Als je echt je conversietrend wil zien, zul je minimaal moeten segmenteren tot op bijvoorbeeld het SEO-verkeer op desktop.

- Ervaring is de opeenstapeling van fouten waarvan we hebben geleerd

Deel altijd de lessen die je leert om het A/B- testproces in jouw organisatie naar het volgende niveau te brengen.

Gerelateerde special

Deel dit bericht

Plaats een reactie

Uw e-mailadres wordt niet op de site getoond

3 Reacties

leonard wolters

Erg leuk en verhelderend artikel. Thanks!

Peter

Graag gedaan! Leuk te horen dat je er iets aan hebt gehad!

Martin Voorzanger

De serie is compleet. Vond ‘m erg goed. Mede omdat veel best-practices en white papers over A/B testing van de hand van tooling leveranciers komen en niet de praktijkervaringen van agencies (zoals OrangeValley in dit geval) meenemen.